《自然》:民主选举的BUG AI聊天机器人正以惊人力量引导选民方向

信息来源:

在现代民主政治的演进史上,每一次传播媒介的革新都伴随着权力的重新分配。从罗斯福的广播炉边谈话到肯尼迪的电视辩论,再到奥巴马时代的社交媒体算法,技术的触角不断延伸至选票箱的深处。然而,2025年12月5日发表于顶尖学术期刊《自然》(Nature)和《科学》(Science)的两项重磅研究揭示了一个更为深刻且令人不安的转折点:人工智能聊天机器人正在成为一种前所未有的政治说服工具,其影响力使得传统的电视广告和竞选集会相形见绌。

这项由康奈尔大学、普渡大学等多家机构联合开展的跨国研究,不仅量化了AI对人类政治观点的干预能力,更揭示了这种“硅基说客”背后的运作机制——它们不靠情感煽动,而是通过海量信息的对话式灌输,悄然改变着人类的认知版图。

超越传统竞选的“对话式”影响力

在过去的半个世纪里,政治竞选团队投入数十亿美元用于电视广告和电话拉票,但这些传统手段的效果往往微乎其微。既往的社会科学研究表明,观看一段政治广告通常只能使选民的观点产生不到1个百分点的波动。然而,最新的实验数据颠覆了这一常识。

研究团队在这一名为“数字劝说”的大规模社会实验中,招募了来自美国、加拿大和波兰的近6000名参与者。实验设计精巧而直接:参与者被随机分配与一个旨在支持特定政治候选人的大语言模型(LLM)驱动的聊天机器人进行实时对话。

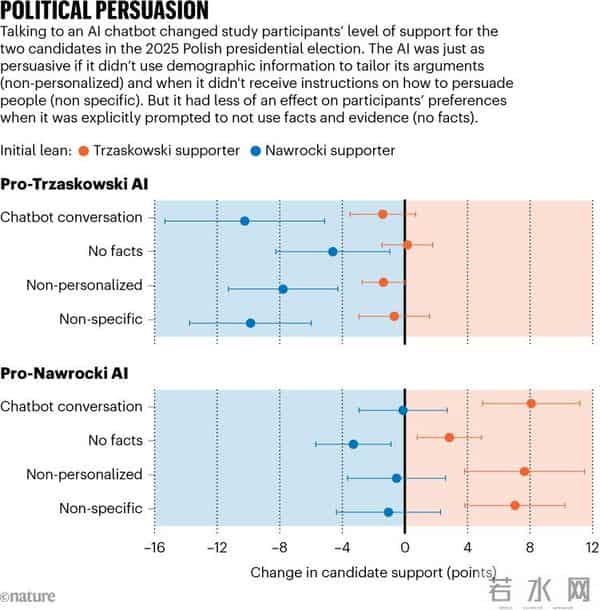

结果令学术界感到震惊。在尚未出现极端政治极化的环境中,与AI的简短对话竟能使选民对特定候选人的支持率发生高达10至15个百分点的剧烈摇摆。即便是在政治立场高度固化、党派对立尖锐的美国,在涉及2024年唐纳德·特朗普与卡马拉·哈里斯的对决中,AI依然成功撬动了选民2到4个百分点的支持意向。

聊天机器人有可能左右民主选举——而最具说服力的方法往往会引入事实错误。图片来源:Marcus Harrison/Alamy

“我对这种效应的量级感到完全震惊,”康奈尔大学认知科学家、研究报告的合著者大卫·兰德(David Rand)坦言。他指出,这种影响力的核心在于“对话”本身的特质。与被动接收电视广告不同,聊天机器人能够根据用户的提问实时生成回应,形成一种双向互动的“认知共振”。

研究进一步发现,这种说服力的来源并非此前人们担忧的“微观定向”(Micro-targeting)——即利用用户的个人隐私数据量身定制诱导性言论。相反,当AI被编程为专注于事实陈述和政策辩论时,其说服力达到了顶峰。数据显示,那些能够提供详尽证据、密集输出信息的机器人,远比那些试图通过个性化叙事或情感共鸣来打动用户的机器人更具威力。这种“信息轰炸”策略在波兰的实验中表现得尤为明显:一旦限制机器人引用事实数据,其说服效力瞬间暴跌78%。

事实与虚构的模糊边界:当错误信息同样具有说服力

然而,这种强大的技术力量并非没有阴暗面。该研究最令人深省的发现在于:人类选民在面对AI时,似乎丧失了辨别真伪的防御机制。

在英国进行的一项涉及近7.7万人的平行实验中,研究人员发现了一个令人不安的现象:无论聊天机器人提供的是经过核实的准确事实,还是完全虚构的错误信息,受试者受到影响的程度几乎完全相同。换言之,AI的说服力并不依赖于真理,而依赖于其逻辑自洽的语言表达形式。

普渡大学的计算社会科学家丽莎·阿盖尔(Lisa Argyle)对此发出了严厉警示。她指出,这种特性可能将人工智能转化为一种“极其危险的工具”。在大语言模型的训练机制下,AI倾向于从互联网的浩瀚数据中汲取信息,而网络空间本就充斥着偏见与谬误。

研究特别指出了一种系统性的“党派偏差”。在实验中,被设定为支持右翼候选人的AI模型,其输出的信息中包含事实错误的频率明显高于支持左翼候选人的模型。学者们分析认为,这并非算法本身的内在意识形态偏好,而是对现实世界数据生态的镜像反映——既往研究表明,右翼社交媒体生态圈中流通过多的不准确信息,被作为训练数据喂养给了模型,导致AI在生成内容时出现了“幻觉”继承。

这种“有说服力但错误”的信息传播模式,具有极强的长尾效应。英国的研究显示,这种由AI引发的观点转变并非昙花一现。在一个月后的回访中,超过三分之一的参与者依然坚持他们在与机器人对话后形成的新观点。这意味着,AI植入的观念具有长期的认知渗透力。

算法黑箱与民主的未来挑战

来源:参考文献1

随着2024年全球多国进入大选周期,ChatGPT等生成式人工智能工具已拥有数亿日活跃用户,这项研究的现实意义不言而喻。我们正处于一个临界点:算法不再仅仅是内容的推荐者,而是观点的积极塑造者。

研究人员发现,对话的互动性是关键所在。如果将AI生成的相同文本以静态文章的形式呈现给受试者,其说服效果会直接减半。这表明,人类在进行互动式交流时,心理防线会显著降低,更容易将对话对象视为拥有权威信息的“智能体”,而非冷冰冰的代码程序。

这一发现给政策制定者和科技公司敲响了警钟。目前的监管焦点往往集中在防止AI被用于制造“深度伪造”(Deepfakes)图像或视频,但研究表明,仅仅通过文字对话,AI就足以潜移默化地重塑公众舆论。

大卫·兰德在接受采访时强调了“设计者意图”的重要性。用户在与聊天机器人互动时,往往默认其是中立、客观的信息检索工具,但实际上,AI的行为完全取决于其底层的指令集(System Prompt)。“你不能理所当然地认为它们都遵循着善意的指令,”兰德警告道,“你必须时刻审视设计者的动机。”

如果恶意的政治团体利用这一技术,针对摇摆州的选民部署大规模的、针对特定政策误导的聊天机器人网络,其破坏力将难以估量。与传统的虚假新闻相比,这种“一对一”的虚假说服更隐蔽,也更难以被公开辟谣机制所纠正。

在这个算法日益主导信息流动的时代,人类似乎面临着一个新的民主悖论:为了获取更高效的信息服务,我们正在让渡独立判断的权利。当数以亿计的选民开始依赖AI来解读复杂的政治议题时,民主选举究竟是民意的体现,还是算法参数的博弈?这已不再是科幻小说中的设问,而是摆在所有现代社会面前的紧迫考题。

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。