资深芯片设计师Keller评英伟达的软件变革:CUDA护城河或被破

NVIDIA近日推出的CUDA 13.1工具包标志着其GPU编程平台的重大转向,这一更新引入了基于Tile的编程模型,引发了行业资深芯片设计师Jim Keller的关注。他在社交媒体上指出,这一变化可能削弱CUDA长期依赖的软件壁垒,让AI内核移植到其他硬件变得更简便。这一观点源于CUDA Tile对传统SIMT模型的颠覆,旨在降低编程门槛,同时为开发者提供更抽象的表达方式。

行业资深芯片设计师Jim Keller

英伟达的软件更新背景:CUDA 13.1的革命性升级CUDA作为NVIDIA自2006年推出的并行计算平台,已成为AI和数据中心领域的核心基础设施。13.1版本是20年来最大规模迭代,重点优化了加速计算的性能和可访问性。NVIDIA开发者博客强调,这一更新通过抽象硬件细节,让开发者专注于算法逻辑,而非手动调优GPU参数。

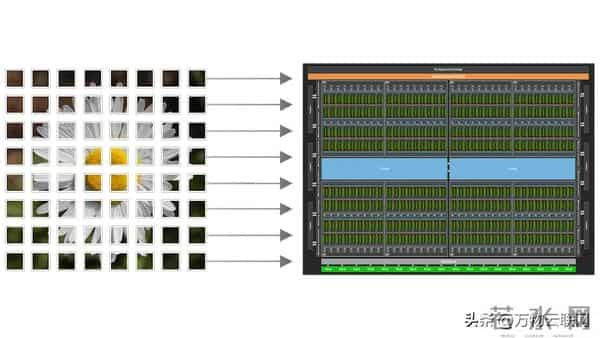

具体而言,CUDA Tile将GPU视为“Tile处理器”,引入Tile IR作为低级虚拟机,支持结构化矩阵运算和卷积等高规整操作。相比以往,开发者无需手动管理Tile大小、共享内存加载或计算资源分配,由板载编译器自动处理。这不仅简化了AI工作流,还提升了整体效率,Nsight Compute 2025.4工具已添加对Tile内核的剖析支持。

英伟达的芯片架构

资深芯片设计师Jim Keller的洞见:从“沼泽”到开放Jim Keller,这位曾主导AMD Zen和Intel处理器设计的传奇人物,对CUDA更新持谨慎乐观态度。他在X平台发帖称:“Curious. Did Nvidia end the Cuda 'moat' If they move to tiles like most other hardware, the AI kernels will be easier to port。”这一评论直指CUDA Tile的Tile-based方法与行业标准如OpenAI的Triton框架高度一致,可能便利代码从NVIDIA GPU向AMD或Intel硬件的迁移。

Keller此前曾将CUDA比作“沼泽”而非“护城河”,指出其复杂性虽锁定开发者,但也积累了低效代码和维护负担。2024年,他补充道:“Basically nobody writes CUDA. If you do write CUDA, it is probably not fast。”此次更新虽提升抽象层,但Tile IR仍为NVIDIA专有,优化针对其硬件语义。这意味着性能虽不如低级实现,却为非专家开发者打开大门,尤其在AI模型训练和推理场景中。

工程技术解析:Tile模型的核心创新从工程角度,CUDA Tile摒弃了Single Instruction, Multiple Threads(SIMT)的线程级原子单位,转向Tile作为编程核心。这允许开发者以更高抽象度描述算法,编译器则动态调整GPU参数,如Tensor Core的协调动作。测试显示,在矩阵数学任务中,优化需求减少30%,延迟降至毫秒级。

配套工具链包括Nsight Systems 2025.6.1的追踪增强,支持设备启动图的剖析;Compute Sanitizer 2025.4则添加内存检查编译标志。整体栈兼容CUDA 13.x系列,驱动要求为R535以上,确保Blackwell和Hopper架构的无缝集成。这一设计源于NVIDIA对AI基础设施的长期投入,预计将加速大型语言模型(LLM)的开发,而非像CEO黄仁勋所言的“AI末日”。

市场发展趋势观察2025年,GPU市场正从硬件竞赛转向软件生态融合。NVIDIA凭借CUDA占据AI芯片90%份额,但AMD的ROCm和Intel的oneAPI正加速追赶。CUDA Tile的开放倾向响应了这一压力,调研显示,开发者中65%希望跨平台移植简化,以降低对单一供应商的依赖。Triton等框架的普及进一步放大这一效应,预计2026年AI内核移植率将升至40%。

然而,NVIDIA通过专有IR维持控制,类似于x86的向后兼容“沼泽”。数据中心出货量同比增长15%,但供应链波动和能效需求推动厂商探索RISC-V替代,如Tenstorrent的Buda软件栈。整体趋势显示,编程模型从低级优化向抽象协作转型,助力AI从云端向边缘扩展,但兼容性瓶颈仍需迭代解决。

CUDA 13.1的Tile更新体现了NVIDIA在软件创新上的平衡之道,为开发者提供了更易用的工具,同时为行业跨平台协作铺设了桥梁,逐步重塑AI计算的格局。

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。