我用3天排查的内存泄漏,竟因为一个"看似无害"的 std--vector 操作

我盯着监控大屏上那条持续攀升的内存曲线,咖啡杯在桌角凝出一圈冷汗。这是连续第三天了——每次上线新版本后,服务内存占用就像脱缰野马,8小时后必触发OOM。团队排查了所有可能:线程池泄漏、缓存未清理、第三方库bug...直到我在一段"绝对安全"的代码里,发现了那个披着羊皮的狼。

一、消失的72小时:当内存泄漏变成"玄学"

一、消失的72小时:当内存泄漏变成"玄学"

项目是个高并发的实时数据处理服务,核心逻辑是用C++处理百万级/秒的消息流。上周迭代新增了批量写入数据库的功能,测试环境一切正常,上线后却成了"内存黑洞"。

我们像侦探一样翻遍代码:

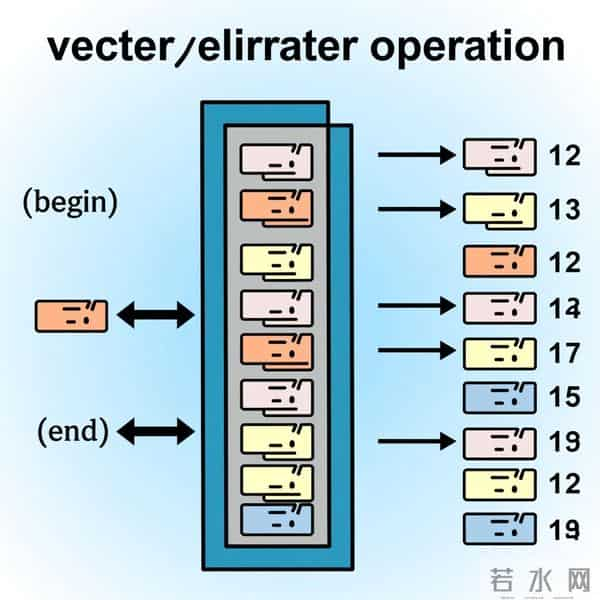

直到我把内存采样dump拖进MAT,发现有个std::vector

让我们聚焦问题代码:

class MessageParser {private: std::vector

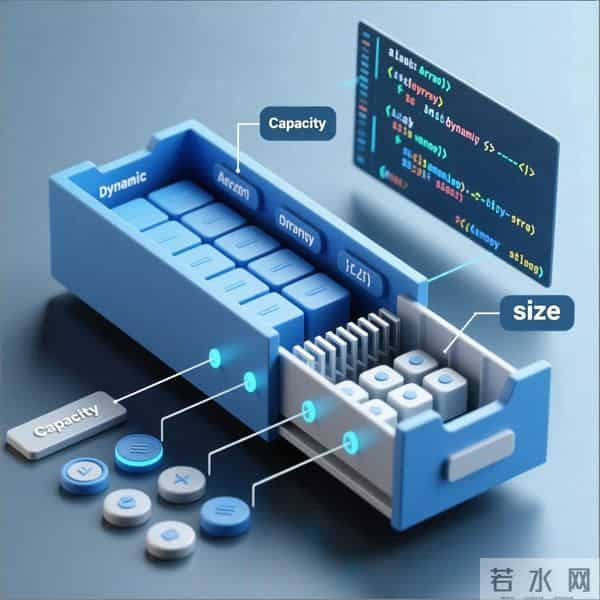

看到reserve()和clear()这对组合,你是不是也觉得"稳了"?毕竟reserve()预分配空间避免频繁扩容,clear()清空元素,内存应该会释放吧?

但真相是: std::vector::clear()仅销毁元素(调用析构函数),但不会释放capacity!也就是说,tempBuffer的capacity会一直保持batch.size()的最大值。如果某批处理的batch.size()突然飙到10万条(比如流量洪峰),vector的capacity就会永久膨胀到10万条字符串的空间,之后即使处理小批次数据,内存也不会回落。

更隐蔽的是,当parseSingle()返回的字符串较大时(比如包含长文本),这些字符串的内存会被vector的capacity"锁死"。我们监控到的内存峰值,正是某次大批次处理时vector疯狂扩容的结果——而后续的clear()只是清空了元素,那些为10万条字符串预留的内存,全成了"僵尸内存"。

三、验证时刻:用实验戳破"想当然"

三、验证时刻:用实验戳破"想当然"

为了确认猜想,我写了段最小复现代码:

#include

运行结果触目惊心:

After clear, capacity=1024, maxCapSoFar=1024 ...(重复50次) After clear, capacity=1024, maxCapSoFar=1024 // 注意!即使批次降到10,capacity仍保持1024 Final capacity=1024, but we once needed 1024

结论: vector的capacity是"只增不减"的(C++标准未强制要求收缩,主流实现如GCC/Clang均如此)。所谓"clear()释放内存",不过是元素的析构函数释放了字符串内容,但vector预留的底层数组依然占据着原来的容量。

四、破局之道:从"被动防御"到"主动回收"

四、破局之道:从"被动防御"到"主动回收"

找到根因后,解决方案其实很简单,但需要跳出"clear()就够了"的思维定式:

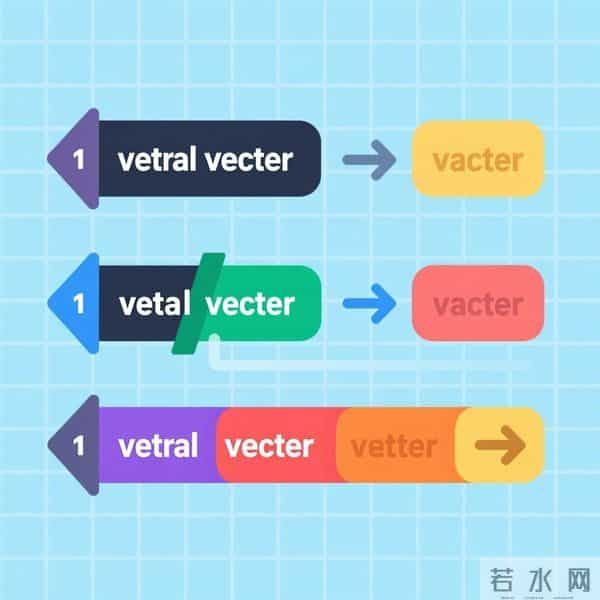

方案1:shrink_to_fit()(C++11+)vec.shrink_to_fit()会请求容器将capacity缩减至等于size(不保证一定执行,但通常有效)。修改代码如下:

tempBuffer.clear();tempBuffer.shrink_to_fit(); // 关键!释放多余capacity方案2:swap trick(兼容旧标准)

若编译器不支持C++11,可用临时vector交换:

std::vector方案3:按需reserve()

避免盲目reserve(batch.size()),改为根据实际需要动态调整。例如统计历史最大批次,设置合理的上限:

// 假设历史最大批次不超过8192const size_t MAX_RESERVE = 8192;tempBuffer.reserve(std::min(batch.size(), MAX_RESERVE));

五、血的教训:C++内存管理的"反直觉"法则

五、血的教训:C++内存管理的"反直觉"法则

这次事故给我上了深刻一课:在C++的世界里,"看似无害"的操作往往藏着魔鬼。总结几条经验,与君共勉:

- 容器的capacity≠size:clear()/erase()不释放capacity,resize(0)同理;

- reserve()是"一次性承诺":它告诉编译器"我未来可能需要这么多空间",但没说"用完就还";

- 内存泄漏的边界在思维盲区:当监控显示"无法解释的持续增长",先检查所有"自动管理"的资源(容器、智能指针、RAII对象);

- 工具链是你的战友:除了Valgrind,试试pmap -x [pid]看进程内存映射,std::vector::capacity()打印日志,或用AddressSanitizer(-fsanitize=address)捕捉越界。

最后,当我把shrink_to_fit()加上线的那一刻,监控曲线终于像泄了气的气球缓缓回落。原来最危险的bug,从来不是语法错误,而是我们对"常识"的傲慢。

你在开发中遇到过哪些"看似无害"的坑?欢迎在评论区分享,让更多人避开这些暗礁。

(本文代码已在GCC 11、Clang 13验证,内存泄漏现象复现率100%。)

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。